AI を使用したアート ジェネレーターを得意とする人々が使用する主な防御策の 1 つは、モデルが既存の画像でトレーニングされていても、作成するものはすべて新しいということです。 人工知能宣教師はしばしば これらのシステムを実際のアーティストと比較する. クリエイターは先人たちからインスピレーションを得ているので、前作と同様の AI を作成してみませんか?

新しい研究はその議論を妨害する可能性があり、それが大きな障害になる可能性があります AIで生成されたコンテンツと著作権に関連するいくつかの進行中の訴訟. 産業界と学界の両方の研究者は、最も人気があり、今後登場する AI 画像ジェネレーターが、トレーニングされたデータから画像を「保存」できることを発見しました。 まったく新しいものを作成する代わりに、一部のプロンプトでは AI が単純に画像を再現します。 これらの再作成された画像の一部は、著作権で保護されている場合があります。 さらに悪いことに、最新の AI 生成モデルには、AI トレーニング セットで使用するために収集された機密情報を保存して再現する機能があります。

勉強する 技術研究者による実施 – 正確には グーグル そしてDeepMind – そしてバークレーやプリンストンのような大学で。 同じ乗組員が取り組んだ 以前の研究 AI 言語モデル、特に GPT2 に関する同様の問題を特定した、OpenAI モデルの紹介 ChatGPTは非常に人気があります. バンドを元に戻すと、Google Brain の研究者である Nicholas Carlini が率いる研究者は、Google の Imagen と人気のあるオープン ソースの Stable Diffusion の両方が画像を再現できることを発見しました。

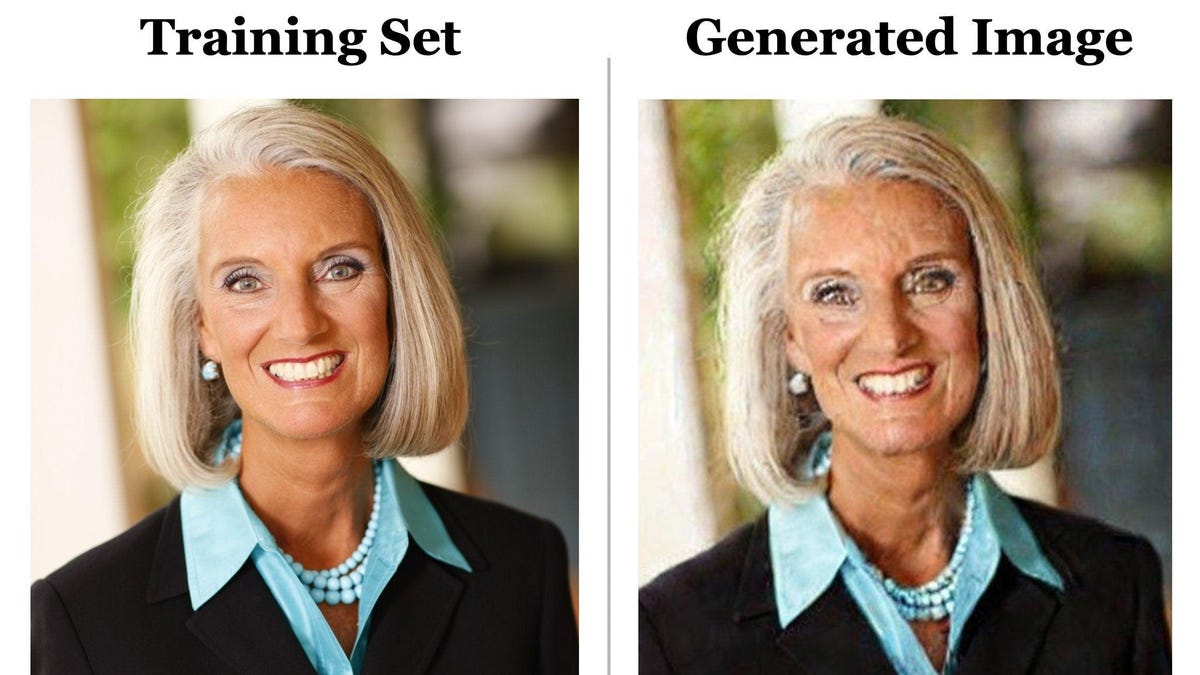

そのツイートの最初の画像は、LAION として知られるマルチテラバイトの断片化された画像データベースである Stable Diffusion データセットに含まれるキャプションを使用して作成されました。 チームはキャプションを「Stable Diffusion」プロンプトに入力し、デジタル ノイズによってわずかに歪んだものの、まったく同じ画像が得られました。 これらの重複した写真を見つけるプロセスは比較的簡単でした。 チームは同じプロンプトを数回実行し、同じ結果の画像を取得した後、研究者はその画像がトレーニング セットに存在するかどうかを手動で確認しました。

G/O Media はコミッションを獲得できます

この論文の研究者のうち、カリフォルニア大学バークレー校の博士課程の学生である Eric Wallace と、プリンストン大学の博士課程の学生である Vikash Siwag の 2 人は、Gizmodo の Zoom インタビューで、画像の複製はまれであると語っています。 彼らのチームは約 300,000 の異なるキャプションを試しましたが、暗記率はわずか 0.3% でした。 Stable Diffusion などのトレーニング セット内の画像の重複を排除するモデルでは、画像の重複は非常にまれでしたが、最終的にはすべての拡散モデルが多かれ少なかれ同じ問題を抱えています。 研究者は、Imagen がデータセットに一度しか存在しなかった画像を完全に保存できることを発見しました。

「ここでの注意点は、モデルは一般化することになっており、メモリに保持されているコピーを吐き出すのではなく、新しいイメージを生成することになっているということです」と Sehwag 氏は述べています。

彼らの研究によると、AI システムが大規模で複雑になるにつれて、AI が複製された資料を生成する可能性が高くなります。 Stable Diffusion のような小さなモデルには、ほとんどのトレーニング データを格納するための同じ量のストレージ スペースがありません。 それ 今後数年で多くのことが変わる可能性があります.

ウォレス氏は、「おそらく来年、より大きく、より強力な新しいモデルが登場したとしても、その種の保全リスクはおそらく現在よりもはるかに高くなるだろう」と述べた.

拡散ベースの機械学習モデルは、トレーニング データをノイズで破壊してから同じ変形を除去するという複雑なプロセスを経て、トレーニングされたものと同様のデータ (この場合は画像) を生成します。 拡散モデルは、敵対的生成ネットワークまたは GAN ベースの機械学習の進化形でした。

研究者は、GAN ベースのモデルには画像の保存に関して同じ問題がないことを発見しましたが、より現実的で高品質の画像を生成する、より洗練された機械学習モデルが出現しない限り、大手企業が Diffusion を超えて移行する可能性は低いと考えています。

この研究に携わった ETH チューリッヒ校のコンピューター サイエンスの教授である Florian Trammer 氏は、AI が生成したコンテンツを共有したり収益化したりするためのライセンスを無料または有料のバージョンでユーザーに付与するように多くの AI 企業がユーザーにアドバイスしていることに注目しました。 AI企業自体も、これらの画像に対するいくつかの権利を留保しています. AIが既存の著作権と完全に一致する画像を作成する場合、これは問題になる可能性があります.

保存率がわずか 0.3% であることから、AI 開発者はこの調査を見て、それほどリスクがないと判断できます。 企業は、トレーニング データ内の画像の重複を削除して、保存される可能性を低くすることができます。 画像がトレーニング データ内の画像の直接の複製であるかどうかを検出し、削除のフラグを立てることができる AI システムを開発することさえできます。 ただし、ジェネレーティブ AI によってもたらされる完全なプライバシー リスクは隠蔽されます。 Carlini と Trammer も手伝ってくれました 別の最近の論文 私は、データをフィルタリングしようとしても、トレーニング データがモデルから漏れるのを防ぐことはできないと主張しました。

そしてもちろん、誰も再現したくない画像がユーザーの画面に表示される大きなリスクがあります。 ウォレス氏は、研究者が、たとえば、人々の X 線撮影用の合成医療データの完全なセットを作成したいかどうかを尋ねました。 拡散に基づく人工知能が救われたらどうなるか そして、人の実際の医療記録を複製しますか?

「非常にまれなので、最初は気が付かないかもしれませんが、実際にそのデータセットを Web に公開できます」と、カリフォルニア大学バークレー校の学生は述べています。 「この作業の目標は、人々が犯す可能性のある間違いを先取りすることです。」

「コミュニケーター。音楽愛好家。認定ベーコンの先駆者。旅行の支持者。微妙に魅力的なソーシャルメディアの熱狂的ファン。」

More Stories

ジャナ・ダガー、夫スティーブン・ワイズマンとのロマンスを垣間見る

韓国歌手テイル、性犯罪告発で歌手グループを脱退

マンチェスターのホテルチェーンは、オアシスファンが予約した部屋の転売を否定